shopify的robots文件简介

蜘蛛访问任何一个网站的时候,都会先访问网站根目录下的Robots.txt文件,如果Robots.txt禁止搜索引擎抓取某些文件或者目录,蜘蛛将会遵守协议,不抓取被禁止的网址。重要性不言而喻。

shopify的robots.txt文件位置

shopify前台没有robots.txt文件,但是后台自动生成一个默认 robots.txt 文件,该文件适用于大多数商店,但是很多规则对于seo并不友好,但您可以通过 新建robots.txt.liquid 模板样式编辑该文件。

robots文件的作用

- 允许或不允许抓取某些 URL

- 为某些爬虫添加抓取延迟规则

- 添加额外的站点地图 URL(网站地图)

- 阻止某些爬虫

shopify如何添加robots文件:

如果您想自定义robots.txt.liquid模板,则需要按照以下步骤添加

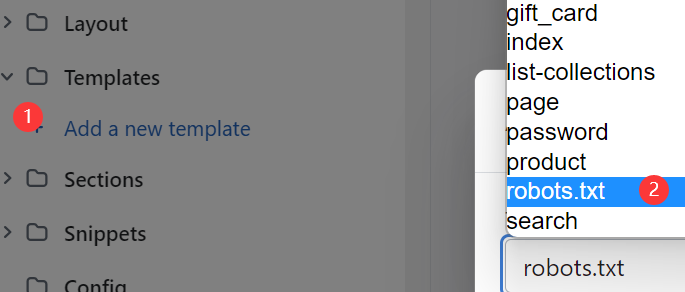

1、在要编辑的主题的代码编辑器中,打开Templates文件夹。

2、单击添加新模板。

3、在“创建新模板”下拉菜单robots.txt下进行选择。

4、单击创建模板。如下图所示:

如何编辑shopify的robots文件

编辑shopify的robots文件就是编辑新建的 robots.txt.liquid文件。会同步产生。

如果您想编辑 robots文件,就需要新建一个robots.txt.liquid那么您应该与 Shopify 专家合作或在代码编辑和 SEO 方面具有专业知识的人来操作。

可以使用robots.txt.liquid 模板中添加或删除指令。此方法使 Shopify 可在将来继续自动更新文件,因此推荐使用此方法。

在编辑 robots.txt.liquid 文件之前,请删除任何以前的自定义项或解决方法,例如使用 Cloudflare 等第三方服务。

如何编辑robots.txt.liquid文件:

向现有组添加新规则指向标题为“向现有组添加新规则”的部分的锚链接

如果您想向现有组添加新规则,则可以调整用于输出默认规则的Liquid以检查关联组并包含您的规则。

例如,您可以使用以下命令来阻止所有爬虫访问带有 URL 参数的页面?q=:

{% for group in robots.default_groups %}

{{- group.user_agent }}

{%- for rule in group.rules -%}

{{ rule }}

{%- endfor -%}

{%- if group.user_agent.value == ‘‘ -%} {{ ‘Disallow: /?q=*’ }}

{%- endif -%}

{%- if group.sitemap != blank -%}

{{ group.sitemap }}

{%- endif -%}

{% endfor %}

70外贸通_外贸跨境电商运营推广网站

70外贸通_外贸跨境电商运营推广网站 QQ登录

QQ登录