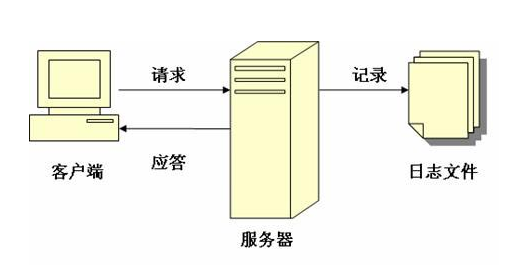

网站日志便是一个网站针对访问者所进行记录的一种流水账形式的日志,该日志通常会存放在网站服务器的根目录下的log文件夹中,通过网站日志可以清楚的得知用户在什么IP、什么时间、用什么操作系统、什么浏览器、什么分辨率显示器的情况下访问了你网站的哪个页面,是否访问成功。

一、查看被搜索引擎抓取的具体信息

在网站日志中主要包含哪些重要信息?

在网站日志中主要包含访问者的IP地址、浏览器信息、客户端终端设备信息、具体访问时间、所访问的具体页面以及上级受访页面以及访问时长等。这些信息之所以重要,有很大一部分因素在于其也可以记录百度蜘蛛等爬虫的行踪,根据在日志中它们的行为来断定它们的意图,从而让网站的优化工作变得更为直观且有迹可循。

如果没有网站日志分析这么一个重要的工具的话,优化一个网站就会显得十分被动,你不知道你的网站到底有没有蜘蛛过来过、搜索引擎的爬虫每天来你网站都抓取了哪些页面以及在你的网站待了多久。而通过这些基本且重要的数据,将会让网站的优化工作变得更为客观。

目录抓取,可以清晰的查看到光顾网站的蜘蛛爬行过哪些目录。要知道:有些目录是没有价值的,如一些图标目录、下载目录、留言目录等,还有后台目录、数据库,如果任由蜘蛛爬行,也是一种安全隐患。另外一方面,搜索引擎对于不同的站点都有着抓取配额,无用目录,更不要占用这样的配额,以免减少有效配额的抓取量。

二、查看页面抓取概况

页面抓取可以准确的查看到蜘蛛爬行的每一个页面,这也是对于LOG日志分析上非常重要的一个环节。如:多重URL链接的抓取?垃圾页面的抓取?都是可以在其中展现出来的。甚至:某个页面抓取频率越高,通常代表这个页面更有价值。

如果你想优化的页面,抓取频率偏低,那么就要为其增加适当的曝光度,来达成你想要的结果。

三、通过网站日志分析出来的重要信息可以为SEO带来什么实际效用?

1、查看访问网站的用户IP、访问页面、停留时间、访问日期等等

2、查看搜索引擎蜘蛛都访问网站那些页面,返回码是什么

3、找出404页面,找出出问题的其他页面,包括死连链接

4、发觉百度蜘蛛每天固定时间来访问网站,那么就可以在固定时间更新网站。

5、访问的页面,有参数(代表动态页面,或者中文URL),三个以上参数的路径不利于优化,那么就有必要写进robots.txt。

6、返回码是不正常的,就有必要处理,让页面恢复正常访问,不能恢复正常访问的死链接,建立txt文档,向百度站长平台提交。

7、404页面可以被百度收录,那么就尽量去恢复网站访问

8、可以排查出一些恶意爬虫以及恶意攻击和恶意采集我们原创文章的ip地址。

9、还可以帮助站长们分析出订单的来源渠道。

而用户状态码,则代表用户的访问情况,在这其中可以清晰的看到用户最为关注哪些页面。不要认为这是小事情,懂得营销的站长,知道投其所好!

上面说的是一些LOG日志工具都有的功能,而接下来我们再说一下一些进阶类型的东西:

A、如果想要更多有效的着陆页被蜘蛛更多的抓取,那么请进行结构内链的完善。

B、不希望蜘蛛抓取那些没有优化意义的页面上,那么robots.txt上来进行封闭。

C、“蜘蛛陷阱”无止尽的循环,浪费抓取配额,通过页面抓取,都可以直观看到。

D、曝光力度够了,蜘蛛一样不抓取,只能说页面价值太低,需要进一步优化。

E、我们希望每个页面的下载时间足够快,可以在有效的时间内抓取更多的页面。

F、不是所有的蜘蛛都是真的蜘蛛,要学会查看蜘蛛是否为“采集”和“模拟”。

G、分析每天的蜘蛛,可以查看上升或者下降的趋势,明显变化,网站会出事的。

H、降低或者封禁不会带来流量的蜘蛛,以减少服务器压力,对大型网站很重要。

四、网站日志的分析工具

这里给大家介绍一款非常好用的网站日志分析工具,就是拉格好分析工具http://www.loghao.com/,可以选择导入日志后进行分析。

当然,网站日志分析还有更深入的内容,也希望大家平时多分析,如果能够分析个3-5次,基本上也就有一个判断,能够更好的知道SEO工作,比如robots文件的制作、404页面的导出处理,死链接的导出处理等等。

70外贸通_外贸跨境电商运营推广网站

70外贸通_外贸跨境电商运营推广网站 QQ登录

QQ登录